Python #81

20

LICENSE

20

LICENSE

@@ -1,20 +0,0 @@

|

||||

MIT License

|

||||

|

||||

Copyright (c) <year> <copyright holders>

|

||||

|

||||

Permission is hereby granted, free of charge, to any person obtaining a copy

|

||||

of this software and associated documentation files (the "Software"), to deal

|

||||

in the Software without restriction, including without limitation the rights

|

||||

to use, copy, modify, merge, publish, distribute, sublicense, and/or sell

|

||||

copies of the Software, and to permit persons to whom the Software is furnished

|

||||

to do so, subject to the following conditions:

|

||||

|

||||

The above copyright notice and this permission notice shall be included in

|

||||

all copies or substantial portions of the Software.

|

||||

|

||||

THE SOFTWARE IS PROVIDED "AS IS", WITHOUT WARRANTY OF ANY KIND, EXPRESS OR

|

||||

IMPLIED, INCLUDING BUT NOT LIMITED TO THE WARRANTIES OF MERCHANTABILITY, FITNESS

|

||||

FOR A PARTICULAR PURPOSE AND NONINFRINGEMENT. IN NO EVENT SHALL THE AUTHORS

|

||||

OR COPYRIGHT HOLDERS BE LIABLE FOR ANY CLAIM, DAMAGES OR OTHER LIABILITY,

|

||||

WHETHER IN AN ACTION OF CONTRACT, TORT OR OTHERWISE, ARISING FROM, OUT OF

|

||||

OR IN CONNECTION WITH THE SOFTWARE OR THE USE OR OTHER DEALINGS IN THE SOFTWARE.

|

||||

1

Plex-Bot-Music

Submodule

1

Plex-Bot-Music

Submodule

Submodule Plex-Bot-Music added at 8f05f5e27f

24

README.md

24

README.md

@@ -1,24 +0,0 @@

|

||||

# Repo Officiel du Discord Plex FR

|

||||

|

||||

## Table des matières

|

||||

* [Qui sommes-nous ?](#qui-sommes-nous)

|

||||

* [A quoi sert ce dépot ?](#a-quoi-sert-ce-dépot)

|

||||

* [Comment contribuer à ce dépot ?](#comment-contribuer-à-ce-dépot)

|

||||

* [Comment nous rejoindre ?](#comment-nous-rejoindre)

|

||||

|

||||

## Qui sommes-nous ?

|

||||

|

||||

Nous sommes une communauté francophone autour du logiciel Plex.

|

||||

...

|

||||

|

||||

## A quoi sert ce dépot ?

|

||||

|

||||

Ce dépot nous sert a stocker les composes / aides / tutos / ... qui nous permettent d'aider la communauté. L'avantage du dépot est que toutes les personnes inscrites peuvent contribuer.

|

||||

|

||||

## Comment contribuer à ce dépot ?

|

||||

|

||||

Lisez le README "Aide pour le repo" ici : https://gitea.zoz-serv.org/Zoz/plex_fr_discord_repo/src/branch/master/README_GIT.md

|

||||

|

||||

## Comment nous rejoindre ?

|

||||

|

||||

Nous sommes sur Discord et Guilded, a ces adresses : https://discord.gg/ERpYMqS | https://guilded.gg/PlexFR

|

||||

115

README_GIT.md

115

README_GIT.md

@@ -1,115 +0,0 @@

|

||||

# AIDE POUR LE REPO

|

||||

|

||||

## Table des matières

|

||||

* [Comment utiliser Git](#comment-utiliser-git)

|

||||

* [Docker-compose](#docker-compose)

|

||||

* [Wiki](#wiki)

|

||||

|

||||

## Comment utiliser Git

|

||||

|

||||

Clonez le dépot sur votre machine `git clone https://gitea.zoz-serv.org/Zoz/plex_fr_discord_repo.git`

|

||||

|

||||

### Pour chaque modification, attention à bien suivre cette procédure si vous voulez éviter des conflits de versions

|

||||

|

||||

- Créez votre branche via la GUI Gitea (idéalement votre pseudo) ex : `Benj`

|

||||

|

||||

|

||||

|

||||

- Rapatriez les dernières modifications : `git pull`

|

||||

- Mettez vous sur votre branche : `git checkout mabranche`

|

||||

- Faites vos modificatiosn (création de fichiers etc)

|

||||

- Récupérez les éventuelles denrières modifications : `git pull` puis `git merge master`

|

||||

- Ajoutez les nouveaux fichiers : `git add .` ou `git add -A`

|

||||

- Validez les modif : `git commit -m "ma super modif"`

|

||||

- Balancez sur le serveur : `git push`

|

||||

- Et ouvrez une merge request via la GUI, pensez à ajouter 1 ou 2 relecteurs, petite parenthèse

|

||||

le but de la relecture par les pairs permet d'éviter des erreurs (https://blog.groupe-sii.com/les-revues-de-code/)

|

||||

|

||||

Quand la merge request est close et/ou mergé, le relecteur supprime votre branche,

|

||||

vous pourrez la recréer plus tard quand vous aurez besoin...

|

||||

|

||||

### Petit reminder

|

||||

|

||||

- **ON NE TRAVAILLE JAMAIS SUR LE MASTER**

|

||||

|

||||

- **Un renommage de répertoire cause un conflit généralement, nécessite intervention manuelle**

|

||||

|

||||

- `git status` > donne la branche courante ainsi que l'état des fichiers modifiés

|

||||

> git status

|

||||

> Sur la branche master

|

||||

> Votre branche est à jour avec 'origin/master'.

|

||||

>

|

||||

> Modifications qui ne seront pas validées :

|

||||

> (utilisez "git add <fichier>..." pour mettre à jour ce qui sera validé)

|

||||

> (utilisez "git checkout -- <fichier>..." pour annuler les modifications dans la copie de travail)

|

||||

>

|

||||

> modifié : README.md

|

||||

>

|

||||

> aucune modification n'a été ajoutée à la validation (utilisez "git add" ou "git commit -a")

|

||||

|

||||

|

||||

- `git add toto.pouet` ou `git add .` > ajout les modifications sur toto.pouet ou sur tous les fichiers au prochain commit

|

||||

|

||||

|

||||

- `git commit -m "mon super message"` > on pose le commit avec un message qui explique ce que l'on a fait (pratique pour retrouver ca plus tard si besoin)

|

||||

|

||||

|

||||

- `git pull` > on récupère toutes les dernières modifs du serveur

|

||||

|

||||

|

||||

- `git merge master` > (doit être fait après un `git pull`) on récupère toutes les dernières modifs du master pour les mettre sur la branche courante

|

||||

|

||||

### Au secours

|

||||

|

||||

#### J'ai fait mes modif sur le master (sans commit)

|

||||

|

||||

- `git stash` > je sauvegarde mes modifs en local et rétablis le dernier commit

|

||||

- `git pull` > je récupère des dernières modifs du serveur

|

||||

- `git checkout mabranche` > je changement de branche

|

||||

- `git merge master` > je récupère les dernières modifs du master sur ma branche

|

||||

- `git stash apply` > j'applique ma sauvegarde local

|

||||

- je poursuis mes modifs et je add/commit/push quand j'ai fini

|

||||

|

||||

## Docker-compose

|

||||

|

||||

### Fonctionnement

|

||||

|

||||

Le répertoire `docker-compose/` contient uniquement les docker-compose de chaque service/application.

|

||||

|

||||

L'arborescence doit être la suivante :

|

||||

`docker-compose/<app>/docker-compose.yml`

|

||||

- `<app>` : le nom de l'application ou service à rajouter

|

||||

|

||||

### Possibilité

|

||||

|

||||

Le bot pourrait appeler le contenu de chaque application selon cette commande

|

||||

`.docker-compose <app>`

|

||||

Il chercherait selon l'url suivant :

|

||||

`https://gitea.zoz-serv.org/Zoz/plex_fr_discord_repo/raw/branch/master/docker-compose/<app>/docker-compose.yml`

|

||||

Si HTTP 200 alors on affiche le contenu retourné

|

||||

Sinon HTTP 404 alors on affiche `la page n'existe pas`

|

||||

|

||||

|

||||

Exemple ok:

|

||||

> `.docker-compose plex`

|

||||

> renvoie le contenu de

|

||||

> https://gitea.zoz-serv.org/Zoz/plex_fr_discord_repo/raw/branch/master/docker-compose/plex/docker-compose.yml

|

||||

|

||||

Exemple ko:

|

||||

> `.docker-compose pouet`

|

||||

> renvoie `La page que vous demandez n'existe pas`

|

||||

|

||||

|

||||

|

||||

## Wiki

|

||||

|

||||

fichiers au format md (markdown)

|

||||

|

||||

### Possibilité

|

||||

|

||||

Le bot pourrait appeler le contenu de chaque application selon cette commande

|

||||

`.wiki <doc>`

|

||||

Il chercherait selon l'url suivant :

|

||||

`https://gitea.zoz-serv.org/Zoz/plex_fr_discord_repo/raw/branch/master/wiki/<doc>.md`

|

||||

Si HTTP 200 alors on affiche le contenu retourné

|

||||

Sinon HTTP 404 alors on affiche `la page n'existe pas`

|

||||

@@ -1,33 +0,0 @@

|

||||

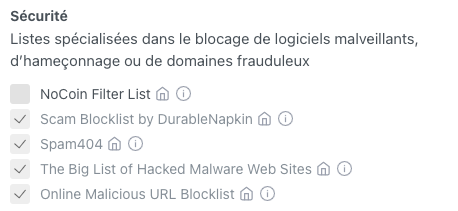

# Liste de blocage DNS pour AdGuard-Home

|

||||

|

||||

## Listes disponibles avec une simple case à cocher :

|

||||

|

||||

* Il faut aller dans le menu **Filtres** -> **Liste de blocage DNS**.

|

||||

|

||||

* Puis, il faut cliquer sur le bouton vert "**Ajouter une liste de blocage**.

|

||||

|

||||

* Et enfin, cliquer sur le bouton "**Choisissez dans la liste**".

|

||||

|

||||

* Choisir ensuite ces listes : (la première est incluse dans une liste à ajouter manuellement ensuite)

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

## Listes à ajouter manuellement (pris dans le fichier de configuration AdGuardHome.yaml) :

|

||||

|

||||

* `Nom de la liste` (à placer dans le champ adéquat) <br/>

|

||||

[URL de la liste](URL)

|

||||

<br/><br/>

|

||||

|

||||

* `sebsauvage.net hosts-adguard`<br/>

|

||||

https://sebsauvage.net/hosts/hosts-adguard

|

||||

|

||||

* `firebog.net - NoTrack-blocklist`<br/>

|

||||

https://gitlab.com/quidsup/notrack-blocklists/raw/master/notrack-blocklist.txt

|

||||

|

||||

* `firebog.net - SmartTV`<br/>

|

||||

https://raw.githubusercontent.com/Perflyst/PiHoleBlocklist/master/SmartTV.txt

|

||||

|

||||

* `Firebog.net - ads-and-tracking-extended`<br/>

|

||||

https://www.github.developerdan.com/hosts/lists/ads-and-tracking-extended.txt

|

||||

@@ -1,50 +0,0 @@

|

||||

https://raw.githubusercontent.com/StevenBlack/hosts/master/hosts

|

||||

https://raw.githubusercontent.com/Akamaru/Pi-Hole-Lists/master/mobile.txt

|

||||

https://raw.githubusercontent.com/Akamaru/Pi-Hole-Lists/master/smarttv.txt

|

||||

https://raw.githubusercontent.com/Akamaru/Pi-Hole-Lists/master/nomsdata.txt

|

||||

https://raw.githubusercontent.com/Akamaru/Pi-Hole-Lists/master/gamefake.txt

|

||||

https://raw.githubusercontent.com/Akamaru/Pi-Hole-Lists/master/jbfake.txt

|

||||

https://raw.githubusercontent.com/Akamaru/Pi-Hole-Lists/master/fakenewsde.txt

|

||||

https://raw.githubusercontent.com/Akamaru/Pi-Hole-Lists/master/adobeblock.txt

|

||||

https://raw.githubusercontent.com/Akamaru/Pi-Hole-Lists/master/other.txt

|

||||

https://justdomains.github.io/blocklists/lists/easylist-justdomains.txt

|

||||

https://raw.githubusercontent.com/kboghdady/youTube_ads_4_pi-hole/master/black.list

|

||||

https://www.github.developerdan.com/hosts/lists/amp-hosts-extended.txt

|

||||

https://www.github.developerdan.com/hosts/lists/tracking-aggressive-extended.txt

|

||||

https://www.github.developerdan.com/hosts/lists/ads-and-tracking-extended.txt

|

||||

https://raw.githubusercontent.com/PolishFiltersTeam/KADhosts/master/KADhosts_without_controversies.txt

|

||||

https://raw.githubusercontent.com/FadeMind/hosts.extras/master/add.Spam/hosts

|

||||

https://v.firebog.net/hosts/static/w3kbl.txt

|

||||

https://adaway.org/hosts.txt

|

||||

https://v.firebog.net/hosts/AdguardDNS.txt

|

||||

https://v.firebog.net/hosts/Admiral.txt

|

||||

https://raw.githubusercontent.com/anudeepND/blacklist/master/adservers.txt

|

||||

https://s3.amazonaws.com/lists.disconnect.me/simple_ad.txt

|

||||

https://v.firebog.net/hosts/Easylist.txt

|

||||

https://pgl.yoyo.org/adservers/serverlist.php?hostformat=hosts&showintro=0&mimetype=plaintext

|

||||

https://raw.githubusercontent.com/FadeMind/hosts.extras/master/UncheckyAds/hosts

|

||||

https://raw.githubusercontent.com/bigdargon/hostsVN/master/hosts

|

||||

https://v.firebog.net/hosts/Easyprivacy.txt

|

||||

https://v.firebog.net/hosts/Prigent-Ads.txt

|

||||

https://gitlab.com/quidsup/notrack-blocklists/raw/master/notrack-blocklist.txt

|

||||

https://raw.githubusercontent.com/FadeMind/hosts.extras/master/add.2o7Net/hosts

|

||||

https://raw.githubusercontent.com/crazy-max/WindowsSpyBlocker/master/data/hosts/spy.txt

|

||||

https://hostfiles.frogeye.fr/firstparty-trackers-hosts.txt

|

||||

https://zerodot1.gitlab.io/CoinBlockerLists/hosts_browser

|

||||

https://raw.githubusercontent.com/DandelionSprout/adfilt/master/Alternate%20versions%20Anti-Malware%20List/AntiMalwareHosts.txt

|

||||

https://osint.digitalside.it/Threat-Intel/lists/latestdomains.txt

|

||||

https://s3.amazonaws.com/lists.disconnect.me/simple_malvertising.txt

|

||||

https://mirror1.malwaredomains.com/files/justdomains

|

||||

https://v.firebog.net/hosts/Prigent-Crypto.txt

|

||||

https://mirror.cedia.org.ec/malwaredomains/immortal_domains.txt

|

||||

https://www.malwaredomainlist.com/hostslist/hosts.txt

|

||||

https://bitbucket.org/ethanr/dns-blacklists/raw/8575c9f96e5b4a1308f2f12394abd86d0927a4a0/bad_lists/Mandiant_APT1_Report_Appendix_D.txt

|

||||

https://phishing.army/download/phishing_army_blocklist_extended.txt

|

||||

https://gitlab.com/quidsup/notrack-blocklists/raw/master/notrack-malware.txt

|

||||

https://v.firebog.net/hosts/Shalla-mal.txt

|

||||

https://raw.githubusercontent.com/Spam404/lists/master/main-blacklist.txt

|

||||

https://raw.githubusercontent.com/FadeMind/hosts.extras/master/add.Risk/hosts

|

||||

https://urlhaus.abuse.ch/downloads/hostfile/

|

||||

https://emmanuel-lecoq.fr/wp-content/uploads/2020/02/Pi-hole-list.txt

|

||||

https://ransomwaretracker.abuse.ch/downloads/RW_DOMBL.txt

|

||||

https://gitlab.com/ZeroDot1/CoinBlockerLists/raw/master/list.txt

|

||||

@@ -1,16 +0,0 @@

|

||||

# Listes d’autorisation DNS pour AdGuard-Home

|

||||

|

||||

## Listes à ajouter manuellement (pris dans le fichier de configuration AdGuardHome.yaml) :

|

||||

|

||||

- `Nom de la liste` (à placer dans le champ adéquat) <br/>

|

||||

[URL de la liste](URL)

|

||||

<br/><br/>

|

||||

|

||||

* `anudeepND/whitelist`<br/>

|

||||

https://raw.githubusercontent.com/anudeepND/whitelist/master/domains/whitelist.txt

|

||||

|

||||

* `hg1978 / AdGuard-Home-Whitelist`<br/>

|

||||

https://raw.githubusercontent.com/hg1978/AdGuard-Home-Whitelist/master/whitelist.txt

|

||||

|

||||

* `hg1978 / AdGuard-Home-Whitelist`<br/>

|

||||

https://raw.githubusercontent.com/hg1978/AdGuard-Home-Whitelist/master/facebook-whitelist.txt

|

||||

@@ -1,54 +0,0 @@

|

||||

#!/bin/bash

|

||||

|

||||

##===========================================================================================##

|

||||

## Script bridgemacvlan-interface.sh ##

|

||||

## ##

|

||||

## Script de création d'interface virtuelle pour les conteneurs en macvlan ##

|

||||

## Voir tutos : ##

|

||||

## https://www.nas-forum.com/forum/topic/69319-tuto-docker-macvlan-pi-hole/ ##

|

||||

## https://www.nas-forum.com/forum/topic/67311-tuto-certificat-ssl-reverse-proxy-via-docker/ ##

|

||||

## ##

|

||||

## Rappels des différentes IP : ##

|

||||

## - Plage d'IP macvlan : 192.168.xxx.MMM/28 == 192.168.2.208/28 ##

|

||||

## - IP virtuelle unique : 192.168.xxx.zzz/32 == 192.168.2.210/32 ##

|

||||

## - Plage d'IP du LAN : 192.168.xxx.0/24 == 192.168.2.0/24 ##

|

||||

## - Passerelle/routeur : 192.168.xxx.1 == 192.168.2.1 ##

|

||||

## - IP conteneur n°1 : 192.168.xxx.yyy == 192.168.2.209 ##

|

||||

## - IP conteneur n°2 : 192.168.xxx.ooo == 192.168.2.210 AdGuard_Home ##

|

||||

## ##

|

||||

##=============================================================================================

|

||||

|

||||

# Set timeout to wait host network is up and running

|

||||

sleep 60

|

||||

|

||||

echo "$(date "+%R:%S - ") Script de création d'une interface virtuelle pour le NAS"

|

||||

echo "$(date "+%R:%S - ") Exécution des commandes..."

|

||||

|

||||

ip link add macv0 link eth0 type macvlan mode bridge # macv0 : est le nom données à l'interface virtuelle

|

||||

# eth0 : est l'interface réseau utilisée sur le NAS (lorsque VMM n'est pas utilisé)

|

||||

# si VMM est utilisé, ce sera ovs_eth0

|

||||

ip addr add 192.168.xxx.zzz/32 dev macv0 # Adresse IP virtuelle 192.168.x.zzz/32 -- Il faut que cette adresse soit libre dans le réseau

|

||||

# et qu'elle ne fasse pas partie du DHCP du routeur/box

|

||||

#

|

||||

#### Dans mon cas, c'est cette commande :

|

||||

#### ip addr add 192.168.2.230/32 dev macv0

|

||||

|

||||

ip link set dev macv0 address 5E:00:01:02:03:04 # MAC adresse pour l'adaptateur ayant l'IP virtuelle

|

||||

# Il faut que l'adresse MAC respecte ces conditions :

|

||||

# - Elle n'existe pas déjà sur mon hôte et sur mon réseau.

|

||||

# - Elle respecte la base hexadécimale, les notations allant de 0 à F.

|

||||

# - Le premier nombre doit être pair, ici 5E = 94 en base 10, c'est donc OK (vous pouvez

|

||||

# utiliser un convertisseur en ligne, ou faire vos divisions euclidiennes).

|

||||

# S'il est impair, vous aurez un message :

|

||||

# RTNETLINK answers: Cannot assign requested address

|

||||

ip link set macv0 up

|

||||

|

||||

ip route add 192.168.xxx.MMM/28 dev macv0 # 192.168.xxx.MMM/28 : Plage d'adresse macvlan

|

||||

# IP réellement disponible : voir les calculateurs internet

|

||||

# Utiliser Portainer ou l'interface Docker ou encore le script : create-macvlan-network.sh

|

||||

#

|

||||

#### Dans mon cas, c'est cette commande :

|

||||

#### ip route add 192.168.2.208/28 dev macv0

|

||||

|

||||

echo "$(date "+%R:%S - ") Script terminé"

|

||||

exit

|

||||

@@ -1,86 +0,0 @@

|

||||

##==============================================================================================

|

||||

## ##

|

||||

## Fichier docker-compose.yml pour Adguard-Home en macvlan ##

|

||||

## ##

|

||||

##==============================================================================================

|

||||

|

||||

##============================================================================================##

|

||||

## ##

|

||||

## Attention, il faut créer le réseau macvlan à l'aide du script : macvlan-network.sh ##

|

||||

## Ce dernier va créer un réseau macvlan ayant comme IP unique 192.168.2.210 ##

|

||||

## Cette IP doit être dans la plage d'IP mavclan définie dans le script de création du réseau.##

|

||||

## Le conteneur sera donc vu comme une machine sur le réseau LAN, mais ne pourra pas être ##

|

||||

## joint par le NAS lui-même. ##

|

||||

## Pour celà, il faut utiliser le second script : boot-bridgemacvlan-interface.sh ##

|

||||

## Ce dernier va créer une IP-interface virtuelle qui pourra être accessible par le NAS. ##

|

||||

## Cette interface ne persiste pas au démarrage, il faudra mettre le script en tâche ##

|

||||

## planifiée avec le planificateur de tâches dans DSM. ##

|

||||

## ##

|

||||

## Voir tuto : https://www.nas-forum.com/forum/topic/69319-tuto-docker-macvlan-pi-hole/ ##

|

||||

## ##

|

||||

## Attention ! ##

|

||||

## ##

|

||||

## Ces deux scripts ne sont à utiliser qu'une seule fois, quelque soit le nombre de ##

|

||||

## conteneurs qui en bénéficieront. ##

|

||||

## Par exemple, si vous utilisez 2 conteneurs en macvlan, une fois le réseau macvlan créé ##

|

||||

## pour le 1er, il est inutile (et impossible) de le recréer. ##

|

||||

## Le script boot-bridgemacvlan-interface.sh ne doit être lancé qu'une seule fois, et à ##

|

||||

## chaque reboot. L'IP virtuelle est unique, il ne faut pas en recréer une seconde. ##

|

||||

## ##

|

||||

##==============================================================================================

|

||||

|

||||

---

|

||||

version: "2.4"

|

||||

services:

|

||||

adguardhome_macvlan:

|

||||

image: adguard/adguardhome:latest # https://github.com/AdguardTeam/AdGuardHome

|

||||

# https://github.com/AdguardTeam/AdGuardHome/wiki/Docker

|

||||

container_name: adguardhome_macvlan

|

||||

|

||||

hostname: AdGuard-Home--DS920+ # Permet d'avoir un nom pour le conteneur dans AdGuard lui même (sinon c'est une chaine aléatoire)

|

||||

|

||||

environment:

|

||||

- PUID=1000 # Utiliser la commande (en SSH) : id NOM_UTILISATEUR

|

||||

- PGID=100 # Utiliser la commande (en SSH) : id NOM_UTILISATEUR

|

||||

- TZ=Europe/Paris

|

||||

- LANG=fr_FR.UTF8

|

||||

- LANGUAGE=fr_FR.UTF8

|

||||

|

||||

# ---------------------------------------------------------------------------------

|

||||

# Le label ci-dessous permet à Watchtower de faire les mises à jour automatiquement

|

||||

# Cela peut-être supprimé si Watchtower n'est pas utilisé.

|

||||

labels:

|

||||

- "com.centurylinklabs.watchtower.enable=true"

|

||||

# ---------------------------------------------------------------------------------

|

||||

|

||||

volumes:

|

||||

- "/volume1/docker/adguardhome_macvlan/work:/opt/adguardhome/work"

|

||||

- "/volume1/docker/adguardhome_macvlan/conf:/opt/adguardhome/conf"

|

||||

|

||||

# La déclaration des ports n'est pas utile lors d'une installation en macvlan, car tous les ports seront directement accessible

|

||||

# avec l'IP virtuelle.

|

||||

# ports:

|

||||

# - "953:53"

|

||||

# - "967:67/udp"

|

||||

# - "968:68"

|

||||

# - "8080:80/tcp"

|

||||

# - "9443:443/tcp"

|

||||

# - "9853:853/tcp"

|

||||

# - "3030:3000/tcp"

|

||||

|

||||

networks:

|

||||

macvlan-network:

|

||||

ipv4_address: 192.168.xxx.yyy # Mettre ici l'IP macvlan dans la plage définie dans les scripts

|

||||

# Dans mon cas c'est 192.168.2.210

|

||||

|

||||

restart: unless-stopped

|

||||

|

||||

healthcheck:

|

||||

test: "/bin/netstat -pant | /bin/grep 53"

|

||||

interval: 45s

|

||||

timeout: 30s

|

||||

retries: 3

|

||||

|

||||

networks:

|

||||

macvlan-network: # Ce réseau devra bien entendu être créé avant avec le script annexe ou avec Portainer.

|

||||

external: true

|

||||

@@ -1,59 +0,0 @@

|

||||

#!/bin/bash

|

||||

|

||||

##============================================================================================##

|

||||

## ##

|

||||

## Script docker_network_create_macvlan.sh ##

|

||||

## ##

|

||||

## Script de création d'interface virtuelle pour les conteneurs qui auront une IP macvlan ##

|

||||

## Voir tutos : ##

|

||||

## https://www.nas-forum.com/forum/topic/69319-tuto-docker-macvlan-pi-hole/ ##

|

||||

## https://www.nas-forum.com/forum/topic/67311-tuto-certificat-ssl-reverse-proxy-via-docker/ ##

|

||||

## ##

|

||||

## Les IPs prévues pour les conteneurs sont : ##

|

||||

## - Conteneur A : 192.168.xxx.yyy ##

|

||||

## - AdGuard-Home : 192.168.xxx.ooo ##

|

||||

## ##

|

||||

## Rappels des différentes IP : ##

|

||||

## - Plage d'IP macvlan : 192.168.xxx.MMM/28 ##

|

||||

## - IP virtuelle unique : 192.168.xxx.zzz/32 ##

|

||||

## - IP conteneur n°1 : 192.168.xxx.yyy ##

|

||||

## - IP conteneur n°2 : 192.168.xxx.ooo ##

|

||||

## - Plage d'IP du LAN : 192.168.xxx.0/24 ##

|

||||

## - Passerelle/routeur : 192.168.xxx.1 ##

|

||||

## ##

|

||||

##==============================================================================================

|

||||

|

||||

##==============================================================================================

|

||||

## ##

|

||||

## --ip-range=192.168.xxx.MMM/28 : cela correspond à la plage d'IP pour le réseau macvlan ##

|

||||

## sachant que 192.168.xxx.MMM doit être la 1ère IP donnée par les calculateurs internet. ##

|

||||

## Il se peut que ce ne soit pas la même que l'IP macvlan que l'on veut donner au conteneur ##

|

||||

## AdGuardHome. ##

|

||||

## ##

|

||||

## Quelques calculateurs internet : ##

|

||||

## https://cric.grenoble.cnrs.fr/Administrateurs/Outils/CalculMasque/ ##

|

||||

## https://www.cidr.eu/en/calculator/+/192.168.2.208/28 ##

|

||||

## ##

|

||||

##==============================================================================================

|

||||

|

||||

|

||||

docker network create -d macvlan \

|

||||

--subnet=192.168.xxx.0/24 \

|

||||

--ip-range=192.168.xxx.MMM/28 \

|

||||

--gateway=192.168.xxx.1 \

|

||||

-o parent=eth0 \ # Ici, eth0 est à remplacer par votre interface réseau : eth0, ovs_eth0 ou autre...

|

||||

macvlan-network

|

||||

|

||||

##==============================================================================================

|

||||

## Pour exemple, voilà mes valeurs à moi : ##

|

||||

## ##

|

||||

## - Conteneur A : 192.168.2.209 ##

|

||||

## - AdGuard-Home : 192.168.2.210 ##

|

||||

## - Conteneur B : 192.168.2.211 ##

|

||||

## ##

|

||||

## Rappels des différentes IP : ##

|

||||

## - Plage d'IP macvlan : 192.168.xxx.MMM/28 == 192.168.2.208/28 ##

|

||||

## - IP virtuelle unique : 192.168.xxx.zzz/32 == 192.168.2.210/32 ##

|

||||

## - Plage d'IP du LAN : 192.168.xxx.0/24 == 192.168.2.0/24 ##

|

||||

## - Passerelle/routeur : 192.168.xxx.1 == 192.168.2.1 ##

|

||||

##==============================================================================================

|

||||

@@ -1,25 +0,0 @@

|

||||

## Discord Plex FR : https://discord.gg/ERpYMqS

|

||||

## Version 2021-02-26

|

||||

version: '3.3'

|

||||

services:

|

||||

adguardhome:

|

||||

container_name: adguardhome

|

||||

volumes:

|

||||

- /volume1/docker/adguard/work:/opt/adguardhome/work

|

||||

- /volume1/docker/adguard/conf:/opt/adguardhome/conf

|

||||

ports:

|

||||

- '53:53/tcp'

|

||||

- '53:53/udp'

|

||||

- '80:80/tcp' # WebUI suite config validé

|

||||

- '3000:3000/tcp' # WebUI 1ere connexion pour configurer

|

||||

- '443:443/tcp'

|

||||

- '853:853/tcp'

|

||||

image: adguard/adguardhome

|

||||

# Network conseillé de ne pas utiliser host (pas de redirection de port) ni default_bridge car limité a 16 ip

|

||||

# Si vous souhaiter utiliser le serveur dhcp il faut utiliser host

|

||||

network_mode: adguard_network

|

||||

restart: unless-stopped

|

||||

# Decommenter les 2 lignes suivantes pour que watchtower surveille ce conteneur

|

||||

# labels:

|

||||

# - com.centurylinklabs.watchtower.enable=true

|

||||

|

||||

@@ -1,21 +0,0 @@

|

||||

## Discord Plex FR : https://discord.gg/ERpYMqS

|

||||

## Version 2021-02-26

|

||||

version: '3'

|

||||

|

||||

services:

|

||||

bitwarden:

|

||||

image: bitwardenrs/server

|

||||

restart: unless-stopped

|

||||

# Decommenter les 2 lignes suivantes pour que watchtower surveille ce conteneur

|

||||

# labels:

|

||||

# - com.centurylinklabs.watchtower.enable=true

|

||||

ports:

|

||||

- 80:80 # WebUI

|

||||

volumes:

|

||||

- /volume1/docker/bitwarden/bw-data:/data

|

||||

environment:

|

||||

- WEBSOCKET_ENABLED: 'true' # Necessaire pour utiliser websockets

|

||||

- SIGNUPS_ALLOWED: 'true' # Mettre faux une fois le 1er utilisateur creer et redemarrer le conteneur

|

||||

# Network conseillé de ne pas utiliser host (pas de redirection de port) ni default_bridge car limité a 16 ip

|

||||

network_mode: 'bitwardenrs_network'

|

||||

|

||||

@@ -1,19 +0,0 @@

|

||||

## Discord Plex FR : https://discord.gg/ERpYMqS

|

||||

## Version 2021-03-03

|

||||

version: '3.3'

|

||||

services:

|

||||

linuxserver:

|

||||

container_name: duckdns

|

||||

environment:

|

||||

- PUID=1000 # Utiliser la commande (en SSH) : id NOM_UTILISATEUR

|

||||

- PGID=1000 # Utiliser la commande (en SSH) : id NOM_UTILISATEUR

|

||||

- TZ=Europe/Paris

|

||||

- SUBDOMAINS=XXXXX # Votre subdomain duckdns sans www

|

||||

- TOKEN=XXXXX # A récupéré sur le site de duckdns

|

||||

restart: unless-stopped

|

||||

# Decommenter les 2 lignes suivantes pour que watchtower surveille ce conteneur

|

||||

# labels:

|

||||

# - com.centurylinklabs.watchtower.enable=true

|

||||

image: 'ghcr.io/linuxserver/duckdns:latest'

|

||||

# Network conseillé de ne pas utiliser host (pas de redirection de port) ni default_bridge car limité a 16 ip

|

||||

network_mode: duckdns_network

|

||||

@@ -1,90 +0,0 @@

|

||||

##==============================================================================================

|

||||

## ##

|

||||

## Docker-compose file for Fail2ban ##

|

||||

## ##

|

||||

##==============================================================================================

|

||||

|

||||

---

|

||||

version: "2"

|

||||

##==============================================================================================

|

||||

## ##

|

||||

## Sources utilisées pour personnaliser ce fichier et ceux dans les sous-dossiers ##

|

||||

## ##

|

||||

##==============================================================================================

|

||||

## ##

|

||||

## https://www.linode.com/docs/guides/using-fail2ban-to-secure-your-server-a-tutorial/ ##

|

||||

## https://www.linuxtricks.fr/wiki/print.php?id=40 ##

|

||||

## https://github.com/dani-garcia/bitwarden_rs/wiki/Fail2Ban-Setup#synology-dsm ##

|

||||

## https://github.com/sosandroid/docker-fail2ban-synology ##

|

||||

## ##

|

||||

##──── ────────────────────────────────────────────────────────────────────────────────────────

|

||||

##──── ────────────────────────────────────────────────────────────────────────────────────────

|

||||

## ##

|

||||

## Cloner/télécharger le dépôt suivant qui contient les fichiers à utiliser : ##

|

||||

## https://github.com/sosandroid/docker-fail2ban-synology.git ##

|

||||

## Il faudra juste modifier le docker-compose.yml qui vient avec ou utiliser celui-ci. ##

|

||||

## ##

|

||||

##──── ────────────────────────────────────────────────────────────────────────────────────────

|

||||

## ##

|

||||

## Pour supprimer une IP bannie, lancer la commande suivante : ##

|

||||

## sudo docker exec -t fail2ban fail2ban-client set bitwarden_rs unbanip xx.xx.xx.xx ##

|

||||

## ##

|

||||

## Pour Voir le log de fail2ban, lancer la commande : ##

|

||||

## cat /volume1/docker/fail2ban/fail2ban.log ##

|

||||

## ##

|

||||

## ##

|

||||

## Quelques commandes utiles : ##

|

||||

## docker exec -t fail2ban fail2ban-client status ##

|

||||

## docker exec -t fail2ban fail2ban-client status bitwarden_rs ##

|

||||

## ##

|

||||

## unbans <IP> (in all jails and database) : ##

|

||||

## docker exec -t fail2ban fail2ban-client unban <IP> ... <IP> ##

|

||||

## ##

|

||||

## docker exec -t fail2ban fail2ban-client --help ##

|

||||

## docker exec -t fail2ban fail2ban-client restart ##

|

||||

## docker exec -t fail2ban fail2ban-client reload --restart --unban --all ##

|

||||

## ##

|

||||

## flushes the logtarget if a file and reopens it. For log rotation. : ##

|

||||

## docker exec -t fail2ban fail2ban-client flushlogs ##

|

||||

## ##

|

||||

##==============================================================================================

|

||||

|

||||

services:

|

||||

fail2ban:

|

||||

image: ghcr.io/crazy-max/fail2ban:latest

|

||||

container_name: fail2ban

|

||||

network_mode: host

|

||||

|

||||

environment:

|

||||

- TZ=Europe/Paris

|

||||

- F2B_DB_PURGE_AGE=30d

|

||||

- F2B_LOG_TARGET=/data/fail2ban.log

|

||||

- F2B_LOG_LEVEL=INFO

|

||||

- F2B_IPTABLES_CHAIN=INPUT

|

||||

|

||||

# Il faut adapter ces variables à votre fournisseur d'email.

|

||||

- SSMTP_HOST=smtp.gmail.com

|

||||

- SSMTP_PORT=587 # Pour gmail : 587

|

||||

- SSMTP_HOSTNAME=Docker-Fail2ban # Ce sera le nom qui sera affiché dans les emails

|

||||

- SSMTP_USER=XXxxXX@gmail.com

|

||||

- SSMTP_PASSWORD=XXxxXX # Pensez à générer un mot de passe application si la 2FA est activée

|

||||

- SSMTP_TLS=YES # Pour gmail : YES

|

||||

- SSMTP_STARTTLS=YES # Pour gmail : YES

|

||||

|

||||

labels:

|

||||

- "com.centurylinklabs.watchtower.enable=true"

|

||||

|

||||

volumes:

|

||||

- "/volume1/docker/fail2ban:/data"

|

||||

|

||||

# Les différents chemins d'accès vers les fichiers log des services à protéger par fail2ban

|

||||

# On ajoute ro pour read-only (lecture seule)

|

||||

- "/volume1/docker/vaultwarden/vaultwarden-data:/vaultwarden:ro" # Vaultwarden

|

||||

- "/volume1/docker/gitea/data/gitea/log:/gitea:ro" # Gitea

|

||||

#- "/var/log/auth.log:/log/host_ssh_auth.log:ro" # SSH sur l'hôte (Synology)

|

||||

|

||||

cap_add:

|

||||

- NET_ADMIN

|

||||

- NET_RAW

|

||||

|

||||

restart: always

|

||||

@@ -1,4 +0,0 @@

|

||||

[Init]

|

||||

blocktype = DROP

|

||||

[Init?family=inet6]

|

||||

blocktype = DROP

|

||||

@@ -1,5 +0,0 @@

|

||||

# /volume1/docker/fail2ban/filter.d/gitea.conf

|

||||

|

||||

[Definition]

|

||||

failregex = .*(Failed authentication attempt|invalid credentials|Attempted access of unknown user).* from <HOST>

|

||||

ignoreregex =

|

||||

@@ -1,8 +0,0 @@

|

||||

# /volume1/docker/fail2ban/filter.d/vaultwarden-admin.conf

|

||||

|

||||

[INCLUDES]

|

||||

before = common.conf

|

||||

|

||||

[Definition]

|

||||

failregex = ^.*Invalid admin token\. IP: <ADDR>.*$

|

||||

ignoreregex =

|

||||

@@ -1,8 +0,0 @@

|

||||

# /volume1/docker/fail2ban/filter.d/vaultwarden.conf

|

||||

|

||||

[INCLUDES]

|

||||

before = common.conf

|

||||

|

||||

[Definition]

|

||||

failregex = ^.*Username or password is incorrect\. Try again\. IP: <ADDR>\. Username:.*$

|

||||

ignoreregex =

|

||||

@@ -1,964 +0,0 @@

|

||||

#

|

||||

# WARNING: heavily refactored in 0.9.0 release. Please review and

|

||||

# customize settings for your setup.

|

||||

#

|

||||

# Changes: in most of the cases you should not modify this

|

||||

# file, but provide customizations in jail.local file,

|

||||

# or separate .conf files under jail.d/ directory, e.g.:

|

||||

#

|

||||

# HOW TO ACTIVATE JAILS:

|

||||

#

|

||||

# YOU SHOULD NOT MODIFY THIS FILE.

|

||||

#

|

||||

# It will probably be overwritten or improved in a distribution update.

|

||||

#

|

||||

# Provide customizations in a jail.local file or a jail.d/customisation.local.

|

||||

# For example to change the default bantime for all jails and to enable the

|

||||

# ssh-iptables jail the following (uncommented) would appear in the .local file.

|

||||

# See man 5 jail.conf for details.

|

||||

#

|

||||

# [DEFAULT]

|

||||

# bantime = 1h

|

||||

#

|

||||

# [sshd]

|

||||

# enabled = true

|

||||

#

|

||||

# See jail.conf(5) man page for more information

|

||||

|

||||

|

||||

|

||||

# Comments: use '#' for comment lines and ';' (following a space) for inline comments

|

||||

|

||||

|

||||

[INCLUDES]

|

||||

|

||||

#before = paths-distro.conf

|

||||

before = paths-debian.conf

|

||||

|

||||

# The DEFAULT allows a global definition of the options. They can be overridden

|

||||

# in each jail afterwards.

|

||||

|

||||

[DEFAULT]

|

||||

|

||||

#

|

||||

# MISCELLANEOUS OPTIONS

|

||||

#

|

||||

|

||||

# "bantime.increment" allows to use database for searching of previously banned ip's to increase a

|

||||

# default ban time using special formula, default it is banTime * 1, 2, 4, 8, 16, 32...

|

||||

#bantime.increment = true

|

||||

|

||||

# "bantime.rndtime" is the max number of seconds using for mixing with random time

|

||||

# to prevent "clever" botnets calculate exact time IP can be unbanned again:

|

||||

#bantime.rndtime =

|

||||

|

||||

# "bantime.maxtime" is the max number of seconds using the ban time can reach (doesn't grow further)

|

||||

#bantime.maxtime =

|

||||

|

||||

# "bantime.factor" is a coefficient to calculate exponent growing of the formula or common multiplier,

|

||||

# default value of factor is 1 and with default value of formula, the ban time

|

||||

# grows by 1, 2, 4, 8, 16 ...

|

||||

#bantime.factor = 1

|

||||

|

||||

# "bantime.formula" used by default to calculate next value of ban time, default value below,

|

||||

# the same ban time growing will be reached by multipliers 1, 2, 4, 8, 16, 32...

|

||||

#bantime.formula = ban.Time * (1<<(ban.Count if ban.Count<20 else 20)) * banFactor

|

||||

#

|

||||

# more aggressive example of formula has the same values only for factor "2.0 / 2.885385" :

|

||||

#bantime.formula = ban.Time * math.exp(float(ban.Count+1)*banFactor)/math.exp(1*banFactor)

|

||||

|

||||

# "bantime.multipliers" used to calculate next value of ban time instead of formula, coresponding

|

||||

# previously ban count and given "bantime.factor" (for multipliers default is 1);

|

||||

# following example grows ban time by 1, 2, 4, 8, 16 ... and if last ban count greater as multipliers count,

|

||||

# always used last multiplier (64 in example), for factor '1' and original ban time 600 - 10.6 hours

|

||||

#bantime.multipliers = 1 2 4 8 16 32 64

|

||||

# following example can be used for small initial ban time (bantime=60) - it grows more aggressive at begin,

|

||||

# for bantime=60 the multipliers are minutes and equal: 1 min, 5 min, 30 min, 1 hour, 5 hour, 12 hour, 1 day, 2 day

|

||||

#bantime.multipliers = 1 5 30 60 300 720 1440 2880

|

||||

|

||||

# "bantime.overalljails" (if true) specifies the search of IP in the database will be executed

|

||||

# cross over all jails, if false (dafault), only current jail of the ban IP will be searched

|

||||

#bantime.overalljails = false

|

||||

|

||||

# --------------------

|

||||

|

||||

# "ignoreself" specifies whether the local resp. own IP addresses should be ignored

|

||||

# (default is true). Fail2ban will not ban a host which matches such addresses.

|

||||

#ignoreself = true

|

||||

|

||||

# "ignoreip" can be a list of IP addresses, CIDR masks or DNS hosts. Fail2ban

|

||||

# will not ban a host which matches an address in this list. Several addresses

|

||||

# can be defined using space (and/or comma) separator.

|

||||

#ignoreip = 127.0.0.1/8 ::1

|

||||

|

||||

# External command that will take an tagged arguments to ignore, e.g. <ip>,

|

||||

# and return true if the IP is to be ignored. False otherwise.

|

||||

#

|

||||

# ignorecommand = /path/to/command <ip>

|

||||

ignorecommand =

|

||||

|

||||

# "bantime" is the number of seconds that a host is banned.

|

||||

bantime = 10m

|

||||

|

||||

# A host is banned if it has generated "maxretry" during the last "findtime"

|

||||

# seconds.

|

||||

findtime = 10m

|

||||

|

||||

# "maxretry" is the number of failures before a host get banned.

|

||||

maxretry = 5

|

||||

|

||||

# "maxmatches" is the number of matches stored in ticket (resolvable via tag <matches> in actions).

|

||||

maxmatches = %(maxretry)s

|

||||

|

||||

# "backend" specifies the backend used to get files modification.

|

||||

# Available options are "pyinotify", "gamin", "polling", "systemd" and "auto".

|

||||

# This option can be overridden in each jail as well.

|

||||

#

|

||||

# pyinotify: requires pyinotify (a file alteration monitor) to be installed.

|

||||

# If pyinotify is not installed, Fail2ban will use auto.

|

||||

# gamin: requires Gamin (a file alteration monitor) to be installed.

|

||||

# If Gamin is not installed, Fail2ban will use auto.

|

||||

# polling: uses a polling algorithm which does not require external libraries.

|

||||

# systemd: uses systemd python library to access the systemd journal.

|

||||

# Specifying "logpath" is not valid for this backend.

|

||||

# See "journalmatch" in the jails associated filter config

|

||||

# auto: will try to use the following backends, in order:

|

||||

# pyinotify, gamin, polling.

|

||||

#

|

||||

# Note: if systemd backend is chosen as the default but you enable a jail

|

||||

# for which logs are present only in its own log files, specify some other

|

||||

# backend for that jail (e.g. polling) and provide empty value for

|

||||

# journalmatch. See https://github.com/fail2ban/fail2ban/issues/959#issuecomment-74901200

|

||||

backend = auto

|

||||

|

||||

# "usedns" specifies if jails should trust hostnames in logs,

|

||||

# warn when DNS lookups are performed, or ignore all hostnames in logs

|

||||

#

|

||||

# yes: if a hostname is encountered, a DNS lookup will be performed.

|

||||

# warn: if a hostname is encountered, a DNS lookup will be performed,

|

||||

# but it will be logged as a warning.

|

||||

# no: if a hostname is encountered, will not be used for banning,

|

||||

# but it will be logged as info.

|

||||

# raw: use raw value (no hostname), allow use it for no-host filters/actions (example user)

|

||||

usedns = warn

|

||||

|

||||

# "logencoding" specifies the encoding of the log files handled by the jail

|

||||

# This is used to decode the lines from the log file.

|

||||

# Typical examples: "ascii", "utf-8"

|

||||

#

|

||||

# auto: will use the system locale setting

|

||||

logencoding = auto

|

||||

|

||||

# "enabled" enables the jails.

|

||||

# By default all jails are disabled, and it should stay this way.

|

||||

# Enable only relevant to your setup jails in your .local or jail.d/*.conf

|

||||

#

|

||||

# true: jail will be enabled and log files will get monitored for changes

|

||||

# false: jail is not enabled

|

||||

enabled = false

|

||||

|

||||

|

||||

# "mode" defines the mode of the filter (see corresponding filter implementation for more info).

|

||||

mode = normal

|

||||

|

||||

# "filter" defines the filter to use by the jail.

|

||||

# By default jails have names matching their filter name

|

||||

#

|

||||

filter = %(__name__)s[mode=%(mode)s]

|

||||

|

||||

|

||||

#

|

||||

# ACTIONS

|

||||

#

|

||||

|

||||

# Some options used for actions

|

||||

|

||||

# Destination email address used solely for the interpolations in

|

||||

# jail.{conf,local,d/*} configuration files.

|

||||

destemail = root@localhost

|

||||

|

||||

# Sender email address used solely for some actions

|

||||

sender = root@<fq-hostname>

|

||||

|

||||

# E-mail action. Since 0.8.1 Fail2Ban uses sendmail MTA for the

|

||||

# mailing. Change mta configuration parameter to mail if you want to

|

||||

# revert to conventional 'mail'.

|

||||

mta = sendmail

|

||||

|

||||

# Default protocol

|

||||

protocol = tcp

|

||||

|

||||

# Specify chain where jumps would need to be added in ban-actions expecting parameter chain

|

||||

chain = <known/chain>

|

||||

|

||||

# Ports to be banned

|

||||

# Usually should be overridden in a particular jail

|

||||

port = 0:65535

|

||||

|

||||

# Format of user-agent https://tools.ietf.org/html/rfc7231#section-5.5.3

|

||||

fail2ban_agent = Fail2Ban/%(fail2ban_version)s

|

||||

|

||||

#

|

||||

# Action shortcuts. To be used to define action parameter

|

||||

|

||||

# Default banning action (e.g. iptables, iptables-new,

|

||||

# iptables-multiport, shorewall, etc) It is used to define

|

||||

# action_* variables. Can be overridden globally or per

|

||||

# section within jail.local file

|

||||

banaction = iptables-multiport

|

||||

banaction_allports = iptables-allports

|

||||

|

||||

# The simplest action to take: ban only

|

||||

action_ = %(banaction)s[port="%(port)s", protocol="%(protocol)s", chain="%(chain)s"]

|

||||

|

||||

# ban & send an e-mail with whois report to the destemail.

|

||||

action_mw = %(action_)s

|

||||

%(mta)s-whois[sender="%(sender)s", dest="%(destemail)s", protocol="%(protocol)s", chain="%(chain)s"]

|

||||

|

||||

# ban & send an e-mail with whois report and relevant log lines

|

||||

# to the destemail.

|

||||

action_mwl = %(action_)s

|

||||

%(mta)s-whois-lines[sender="%(sender)s", dest="%(destemail)s", logpath="%(logpath)s", chain="%(chain)s"]

|

||||

|

||||

# See the IMPORTANT note in action.d/xarf-login-attack for when to use this action

|

||||

#

|

||||

# ban & send a xarf e-mail to abuse contact of IP address and include relevant log lines

|

||||

# to the destemail.

|

||||

action_xarf = %(action_)s

|

||||

xarf-login-attack[service=%(__name__)s, sender="%(sender)s", logpath="%(logpath)s", port="%(port)s"]

|

||||

|

||||

# ban IP on CloudFlare & send an e-mail with whois report and relevant log lines

|

||||

# to the destemail.

|

||||

action_cf_mwl = cloudflare[cfuser="%(cfemail)s", cftoken="%(cfapikey)s"]

|

||||

%(mta)s-whois-lines[sender="%(sender)s", dest="%(destemail)s", logpath="%(logpath)s", chain="%(chain)s"]

|

||||

|

||||

# Report block via blocklist.de fail2ban reporting service API

|

||||

#

|

||||

# See the IMPORTANT note in action.d/blocklist_de.conf for when to use this action.

|

||||

# Specify expected parameters in file action.d/blocklist_de.local or if the interpolation

|

||||

# `action_blocklist_de` used for the action, set value of `blocklist_de_apikey`

|

||||

# in your `jail.local` globally (section [DEFAULT]) or per specific jail section (resp. in

|

||||

# corresponding jail.d/my-jail.local file).

|

||||

#

|

||||

action_blocklist_de = blocklist_de[email="%(sender)s", service="%(__name__)s", apikey="%(blocklist_de_apikey)s", agent="%(fail2ban_agent)s"]

|

||||

|

||||

# Report ban via badips.com, and use as blacklist

|

||||

#

|

||||

# See BadIPsAction docstring in config/action.d/badips.py for

|

||||

# documentation for this action.

|

||||

#

|

||||

# NOTE: This action relies on banaction being present on start and therefore

|

||||

# should be last action defined for a jail.

|

||||

#

|

||||

action_badips = badips.py[category="%(__name__)s", banaction="%(banaction)s", agent="%(fail2ban_agent)s"]

|

||||

#

|

||||

# Report ban via badips.com (uses action.d/badips.conf for reporting only)

|

||||

#

|

||||

action_badips_report = badips[category="%(__name__)s", agent="%(fail2ban_agent)s"]

|

||||

|

||||

# Report ban via abuseipdb.com.

|

||||

#

|

||||

# See action.d/abuseipdb.conf for usage example and details.

|

||||

#

|

||||

action_abuseipdb = abuseipdb

|

||||

|

||||

# Choose default action. To change, just override value of 'action' with the

|

||||

# interpolation to the chosen action shortcut (e.g. action_mw, action_mwl, etc) in jail.local

|

||||

# globally (section [DEFAULT]) or per specific section

|

||||

action = %(action_)s

|

||||

|

||||

|

||||

#

|

||||

# JAILS

|

||||

#

|

||||

|

||||

#

|

||||

# SSH servers

|

||||

#

|

||||

|

||||

[sshd]

|

||||

|

||||

# To use more aggressive sshd modes set filter parameter "mode" in jail.local:

|

||||

# normal (default), ddos, extra or aggressive (combines all).

|

||||

# See "tests/files/logs/sshd" or "filter.d/sshd.conf" for usage example and details.

|

||||

#mode = normal

|

||||

port = ssh

|

||||

logpath = %(sshd_log)s

|

||||

backend = %(sshd_backend)s

|

||||

|

||||

|

||||

[dropbear]

|

||||

|

||||

port = ssh

|

||||

logpath = %(dropbear_log)s

|

||||

backend = %(dropbear_backend)s

|

||||

|

||||

|

||||

[selinux-ssh]

|

||||

|

||||

port = ssh

|

||||

logpath = %(auditd_log)s

|

||||

|

||||

|

||||

#

|

||||

# HTTP servers

|

||||

#

|

||||

|

||||

[apache-auth]

|

||||

|

||||

port = http,https

|

||||

logpath = %(apache_error_log)s

|

||||

|

||||

|

||||

[apache-badbots]

|

||||

# Ban hosts which agent identifies spammer robots crawling the web

|

||||

# for email addresses. The mail outputs are buffered.

|

||||

port = http,https

|

||||

logpath = %(apache_access_log)s

|

||||

bantime = 48h

|

||||

maxretry = 1

|

||||

|

||||

|

||||

[apache-noscript]

|

||||

|

||||

port = http,https

|

||||

logpath = %(apache_error_log)s

|

||||

|

||||

|

||||

[apache-overflows]

|

||||

|

||||

port = http,https

|

||||

logpath = %(apache_error_log)s

|

||||

maxretry = 2

|

||||

|

||||

|

||||

[apache-nohome]

|

||||

|

||||

port = http,https

|

||||

logpath = %(apache_error_log)s

|

||||

maxretry = 2

|

||||

|

||||

|

||||

[apache-botsearch]

|

||||

|

||||

port = http,https

|

||||

logpath = %(apache_error_log)s

|

||||

maxretry = 2

|

||||

|

||||

|

||||

[apache-fakegooglebot]

|

||||

|

||||

port = http,https

|

||||

logpath = %(apache_access_log)s

|

||||

maxretry = 1

|

||||

ignorecommand = %(ignorecommands_dir)s/apache-fakegooglebot <ip>

|

||||

|

||||

|

||||

[apache-modsecurity]

|

||||

|

||||

port = http,https

|

||||

logpath = %(apache_error_log)s

|

||||

maxretry = 2

|

||||

|

||||

|

||||

[apache-shellshock]

|

||||

|

||||

port = http,https

|

||||

logpath = %(apache_error_log)s

|

||||

maxretry = 1

|

||||

|

||||

|

||||

[openhab-auth]

|

||||

|

||||

filter = openhab

|

||||

banaction = %(banaction_allports)s

|

||||

logpath = /opt/openhab/logs/request.log

|

||||

|

||||

|

||||

[nginx-http-auth]

|

||||

|

||||

port = http,https

|

||||

logpath = %(nginx_error_log)s

|

||||

|

||||

# To use 'nginx-limit-req' jail you should have `ngx_http_limit_req_module`

|

||||

# and define `limit_req` and `limit_req_zone` as described in nginx documentation

|

||||

# http://nginx.org/en/docs/http/ngx_http_limit_req_module.html

|

||||

# or for example see in 'config/filter.d/nginx-limit-req.conf'

|

||||

[nginx-limit-req]

|

||||

port = http,https

|

||||

logpath = %(nginx_error_log)s

|

||||

|

||||

[nginx-botsearch]

|

||||

|

||||

port = http,https

|

||||

logpath = %(nginx_error_log)s

|

||||

maxretry = 2

|

||||

|

||||

|

||||

# Ban attackers that try to use PHP's URL-fopen() functionality

|

||||

# through GET/POST variables. - Experimental, with more than a year

|

||||

# of usage in production environments.

|

||||

|

||||

[php-url-fopen]

|

||||

|

||||

port = http,https

|

||||

logpath = %(nginx_access_log)s

|

||||

%(apache_access_log)s

|

||||

|

||||

|

||||

[suhosin]

|

||||

|

||||

port = http,https

|

||||

logpath = %(suhosin_log)s

|

||||

|

||||

|

||||

[lighttpd-auth]

|

||||

# Same as above for Apache's mod_auth

|

||||

# It catches wrong authentifications

|

||||

port = http,https

|

||||

logpath = %(lighttpd_error_log)s

|

||||

|

||||

|

||||

#

|

||||

# Webmail and groupware servers

|

||||

#

|

||||

|

||||

[roundcube-auth]

|

||||

|

||||

port = http,https

|

||||

logpath = %(roundcube_errors_log)s

|

||||

# Use following line in your jail.local if roundcube logs to journal.

|

||||

#backend = %(syslog_backend)s

|

||||

|

||||

|

||||

[openwebmail]

|

||||

|

||||

port = http,https

|

||||

logpath = /var/log/openwebmail.log

|

||||

|

||||

|

||||

[horde]

|

||||

|

||||

port = http,https

|

||||

logpath = /var/log/horde/horde.log

|

||||

|

||||

|

||||

[groupoffice]

|

||||

|

||||

port = http,https

|

||||

logpath = /home/groupoffice/log/info.log

|

||||

|

||||

|

||||

[sogo-auth]

|

||||

# Monitor SOGo groupware server

|

||||

# without proxy this would be:

|

||||

# port = 20000

|

||||

port = http,https

|

||||

logpath = /var/log/sogo/sogo.log

|

||||

|

||||

|

||||

[tine20]

|

||||

|

||||

logpath = /var/log/tine20/tine20.log

|

||||

port = http,https

|

||||

|

||||

|

||||

#

|

||||

# Web Applications

|

||||

#

|

||||

#

|

||||

|

||||

[drupal-auth]

|

||||

|

||||

port = http,https

|

||||

logpath = %(syslog_daemon)s

|

||||

backend = %(syslog_backend)s

|

||||

|

||||

[guacamole]

|

||||

|

||||

port = http,https

|

||||

logpath = /var/log/tomcat*/catalina.out

|

||||

#logpath = /var/log/guacamole.log

|

||||

|

||||

[monit]

|

||||

#Ban clients brute-forcing the monit gui login

|

||||

port = 2812

|

||||

logpath = /var/log/monit

|

||||

/var/log/monit.log

|

||||

|

||||

|

||||

[webmin-auth]

|

||||

|

||||

port = 10000

|

||||

logpath = %(syslog_authpriv)s

|

||||

backend = %(syslog_backend)s

|

||||

|

||||

|

||||

[froxlor-auth]

|

||||

|

||||

port = http,https

|

||||

logpath = %(syslog_authpriv)s

|

||||

backend = %(syslog_backend)s

|

||||

|

||||

|

||||

#

|

||||

# HTTP Proxy servers

|

||||

#

|

||||

#

|

||||

|

||||

[squid]

|

||||

|

||||

port = 80,443,3128,8080

|

||||

logpath = /var/log/squid/access.log

|

||||

|

||||

|

||||

[3proxy]

|

||||

|

||||

port = 3128

|

||||

logpath = /var/log/3proxy.log

|

||||

|

||||

|

||||

#

|

||||

# FTP servers

|

||||

#

|

||||

|

||||

|

||||

[proftpd]

|

||||

|

||||

port = ftp,ftp-data,ftps,ftps-data

|

||||

logpath = %(proftpd_log)s

|

||||

backend = %(proftpd_backend)s

|

||||

|

||||

|

||||

[pure-ftpd]

|

||||

|

||||

port = ftp,ftp-data,ftps,ftps-data

|

||||

logpath = %(pureftpd_log)s

|

||||

backend = %(pureftpd_backend)s

|

||||

|

||||

|

||||

[gssftpd]

|

||||

|

||||

port = ftp,ftp-data,ftps,ftps-data

|

||||

logpath = %(syslog_daemon)s

|

||||

backend = %(syslog_backend)s

|

||||

|

||||

|

||||

[wuftpd]

|

||||

|

||||

port = ftp,ftp-data,ftps,ftps-data

|

||||

logpath = %(wuftpd_log)s

|

||||

backend = %(wuftpd_backend)s

|

||||

|

||||

|

||||

[vsftpd]

|

||||

# or overwrite it in jails.local to be

|

||||

# logpath = %(syslog_authpriv)s

|

||||

# if you want to rely on PAM failed login attempts

|

||||

# vsftpd's failregex should match both of those formats

|

||||

port = ftp,ftp-data,ftps,ftps-data

|

||||

logpath = %(vsftpd_log)s

|

||||

|

||||

|

||||

#

|

||||

# Mail servers

|

||||

#

|

||||

|

||||

# ASSP SMTP Proxy Jail

|

||||

[assp]

|

||||

|

||||

port = smtp,465,submission

|

||||

logpath = /root/path/to/assp/logs/maillog.txt

|

||||

|

||||

|

||||

[courier-smtp]

|

||||

|

||||

port = smtp,465,submission

|

||||

logpath = %(syslog_mail)s

|

||||

backend = %(syslog_backend)s

|

||||

|

||||

|

||||

[postfix]

|

||||

# To use another modes set filter parameter "mode" in jail.local:

|

||||

mode = more

|

||||

port = smtp,465,submission

|

||||

logpath = %(postfix_log)s

|

||||

backend = %(postfix_backend)s

|

||||

|

||||

|

||||

[postfix-rbl]

|

||||

|

||||

filter = postfix[mode=rbl]

|

||||

port = smtp,465,submission

|

||||

logpath = %(postfix_log)s

|

||||

backend = %(postfix_backend)s

|

||||

maxretry = 1

|

||||

|

||||

|

||||

[sendmail-auth]

|

||||

|

||||

port = submission,465,smtp

|

||||

logpath = %(syslog_mail)s

|

||||

backend = %(syslog_backend)s

|

||||

|

||||

|

||||

[sendmail-reject]

|

||||

# To use more aggressive modes set filter parameter "mode" in jail.local:

|

||||

# normal (default), extra or aggressive

|

||||

# See "tests/files/logs/sendmail-reject" or "filter.d/sendmail-reject.conf" for usage example and details.

|

||||

#mode = normal

|

||||

port = smtp,465,submission

|

||||

logpath = %(syslog_mail)s

|

||||

backend = %(syslog_backend)s

|

||||

|

||||

|

||||

[qmail-rbl]

|

||||

|

||||

filter = qmail

|

||||

port = smtp,465,submission

|

||||

logpath = /service/qmail/log/main/current

|

||||

|

||||

|

||||

# dovecot defaults to logging to the mail syslog facility

|

||||

# but can be set by syslog_facility in the dovecot configuration.

|

||||

[dovecot]

|

||||

|

||||

port = pop3,pop3s,imap,imaps,submission,465,sieve

|

||||

logpath = %(dovecot_log)s

|

||||

backend = %(dovecot_backend)s

|

||||

|

||||

|

||||

[sieve]

|

||||

|

||||

port = smtp,465,submission

|

||||

logpath = %(dovecot_log)s

|

||||

backend = %(dovecot_backend)s

|

||||

|

||||

|

||||

[solid-pop3d]

|

||||

|

||||

port = pop3,pop3s

|

||||

logpath = %(solidpop3d_log)s

|

||||

|

||||

|

||||

[exim]

|

||||

# see filter.d/exim.conf for further modes supported from filter:

|

||||

#mode = normal

|

||||

port = smtp,465,submission

|

||||

logpath = %(exim_main_log)s

|

||||

|

||||

|

||||

[exim-spam]

|

||||

|

||||

port = smtp,465,submission

|

||||

logpath = %(exim_main_log)s

|

||||

|

||||

|

||||

[kerio]

|

||||

|

||||

port = imap,smtp,imaps,465

|

||||

logpath = /opt/kerio/mailserver/store/logs/security.log

|

||||

|

||||

|

||||

#

|

||||

# Mail servers authenticators: might be used for smtp,ftp,imap servers, so

|

||||

# all relevant ports get banned

|

||||

#

|

||||

|

||||

[courier-auth]

|

||||

|

||||

port = smtp,465,submission,imap,imaps,pop3,pop3s

|

||||

logpath = %(syslog_mail)s

|

||||

backend = %(syslog_backend)s

|

||||

|

||||

|

||||

[postfix-sasl]

|

||||

|

||||

filter = postfix[mode=auth]

|

||||

port = smtp,465,submission,imap,imaps,pop3,pop3s

|

||||

# You might consider monitoring /var/log/mail.warn instead if you are

|

||||

# running postfix since it would provide the same log lines at the

|

||||

# "warn" level but overall at the smaller filesize.

|

||||

logpath = %(postfix_log)s

|

||||

backend = %(postfix_backend)s

|

||||

|

||||

|

||||

[perdition]

|

||||

|

||||

port = imap,imaps,pop3,pop3s

|

||||

logpath = %(syslog_mail)s

|

||||

backend = %(syslog_backend)s

|

||||

|

||||

|

||||

[squirrelmail]

|

||||

|

||||

port = smtp,465,submission,imap,imap2,imaps,pop3,pop3s,http,https,socks

|

||||

logpath = /var/lib/squirrelmail/prefs/squirrelmail_access_log

|

||||

|

||||

|

||||

[cyrus-imap]

|

||||

|

||||

port = imap,imaps

|

||||

logpath = %(syslog_mail)s

|

||||

backend = %(syslog_backend)s

|

||||

|

||||

|

||||

[uwimap-auth]

|

||||

|

||||

port = imap,imaps

|

||||

logpath = %(syslog_mail)s

|

||||

backend = %(syslog_backend)s

|

||||

|

||||

|

||||

#

|

||||

#

|

||||

# DNS servers

|

||||

#

|

||||

|

||||

|

||||

# !!! WARNING !!!

|

||||

# Since UDP is connection-less protocol, spoofing of IP and imitation

|

||||

# of illegal actions is way too simple. Thus enabling of this filter

|

||||

# might provide an easy way for implementing a DoS against a chosen

|

||||

# victim. See

|

||||

# http://nion.modprobe.de/blog/archives/690-fail2ban-+-dns-fail.html

|

||||